Жизнь 3.0. Быть человеком в эпоху искусственного интеллекта Тегмарк Макс

© Max Tegmark, 2017

© Д. Баюк, перевод на русский язык, 2019

© А. Бондаренко, художественное оформление, макет, 2019

© ООО “Издательство Аст”, 2019

Эта книга издана в рамках программы “Книжные проекты Дмитрия Зимина” и продолжает серию “Библиотека фонда «Династия»”.

Дмитрий Борисович Зимин – основатель компании “Вымпелком” (Beeline), фонда некоммерческих программ “Династия” и фонда “Московское время”.

Программа “Книжные проекты Дмитрия Зимина” объединяет три проекта, хорошо знакомых читательской аудитории: издание научно-популярных книг “Библиотека фонда «Династия»”, издательское направление фонда “Московское время” и премию в области русскоязычной научно-популярной литературы “Просветитель”.

Подробную информацию о “Книжных проектах Дмитрия Зимина” вы найдете на сайте ziminbookprojects.ru

Посвящается команде FLI.

Благодаря им все возможно

Я искренне благодарен всем, кто поддерживал меня и помогал мне во время работы над этой книгой.

И среди них –

моя семья, мои друзья, мои учителя, коллеги и сотрудники, делившиеся со мной идеями и вдохновлявшие меня на протяжении многих лет,

моя мама, подогревавшая мое любопытство в отношении сознания и смысла,

мой папа, не устающий бороться за то, чтобы сделать мир лучше,

мои сыновья Филипп и Александр, показавшие мне, на какие чудеса может быть способен зарождающийся интеллект человеческого уровня,

все энтузиасты науки и техники во всем мире, на протяжении многих лет присылавшие мне свои вопросы и замечания и поощрявшие мое желание разрабатывать и публиковать свои идеи,

мой агент Джон Брокман, выкручивавший мне руки до тех пор, пока я не согласился писать эту книгу,

Боб Пенна, Джесс Тэйлер и Джереми Ингленд, с которыми я обсуждал квазары, сфалероны и каверзы термодинамики,

все те, кто откликнулся по прочтении частей книги в рукописи, включая мою маму, моего брата Пэра, Луизу Бахет, Роба Бенсингера, Катерину Бергстрём, Эрика Бриньоулфссона, Даниелу Читу, Дэвида Чалмерса, Ниму Дегхани, Генри Лина, Элин Мальмскёльд, Тоби Орда, Джереми Оуэна, Лукаса Перри, Энтони Ромеро и Нейт Соареша,

супергерои, которые комментировали гранки всей книги – а именно Мейя, папа, Энтони Агирре, Пол Элмонд, Мэтью Грейвс, Филипп Хелбиг, Ричард Маллах, Дэвид Марбл, Говард Мессинг, Луиньо Сеоане, Марин Сольячич, Яан Таллин и мой издатель Дэн Фрэнк,

а больше всех

Мейя – моя возлюбленная муза и спутница, не устающая меня подбадривать, поддерживать и вдохновлять, без чего эта книга никогда бы не появилась.

Прелюдия

Сказание о команде “Омега”

Группа “Омега” была душой всей компании. Если прочие занимались только тем, как бы выжать побольше денег из различных коммерческих воплощений идеи искусственного интеллекта в ее самом узком смысле, “Омега” пробивалась к тому, что всегда было мечтой Главного – созданию универсального искусственного интеллекта. Подавляющее большинство сотрудников компании смотрело на членов “Омеги” как на пустых мечтателей, ловцов журавлей в небе, отделенных десятилетиями от достижения своих целей. Но все-таки это большинство всячески поощряло членов “Омеги” в их делах: и потому, что престиж компании, который поднимали их прорывные идеи, служил общему благу, и потому, что высоко ценили улучшения в алгоритмах, которые члены “Омеги”, или просто “омеги”, как они сами себя называли, то и дело предлагали.

Однако никто не мог себе даже представить, что образ, тщательно создаваемой для себя “Омегой”, служил ее тайной цели – сокрытию того, что реализация самого амбициозного проекта в человеческой истории была уже совсем близка. Главный так тщательно, по одному, отбирал сотрудников в эту группу не только потому, что они были блестящими исследователями, но и ради удовлетворения своих амбиций, из-за своей приверженности идеалам гуманизма – он хотел быть полезным сразу всем. Он не уставал напоминать своим “омегам” об исключительной опасности того, чем они занимаются: если могущественным правительствам станет хоть что-нибудь известно, они пойдут на все, вплоть до похищения сотрудников, чтобы помешать им, а еще лучше – чтобы выкрасть разрабатываемый ими код. Но “омеги” были на 100 процентов в курсе. Все они пришли в этот проект по тем же самым соображениям, по которым лучшие физики мира пришли когда-то в проект “Манхэттен” по созданию атомной бомбы: они были уверены, что если не сделают ее первыми, ее сделает кто-то, значительно менее приверженный идеалам гуманизма.

Созданный ими искусственный интеллект получил имя Прометея, и его возможности со временем быстро росли. Хотя его когнитивные способности во многих отношениях все еще сильно отставали от человеческих (например, ему плохо давались социальные навыки), но в одном он явно преуспевал – в программировании интеллектуальных систем. “Омеги” умышленно подталкивали его в этом направлении. Такова была их стратегия: они взяли на вооружение аргумент “интеллектуального взрыва”, выдвинутый еще в 1965 году британским математиком Ирвингом Гудом: “Пусть ультраинтеллектуальная машина определяется как машина, значительно превосходящая человека, как бы он ни был умен, в любой интеллектуальной деятельности. Поскольку создание машин – одна из разновидностей такой деятельности, ультраинтеллектуальная машина сможет создавать еще лучшие машины, и тогда, без сомнения, случится “интеллектуальный взрыв”, когда умственные способности человека навсегда безнадежно отстанут. Поэтому ультраинтеллектуальная машина будет последним изобретением, которое нужно сделать человеку, позаботившись о том, чтобы эта машина оказала нам любезность, проинформировав, как удерживать ее под нашим контролем”.

“Омеги” рассудили, что если они смогут запустить подобную рекурсию самоподдерживающихся улучшений, то машина скоро станет достаточно умной, чтобы научить себя и прочим человеческим умениям, которые будут ей полезны.

Первые миллионы

Было девять часов утра пятницы, когда “омеги” решили перекусить. Прометей тихо жужжал в бесконечных компьютерных стойках, выстроенных рядами в просторном, хорошо кондиционированном зале, проход в который строго контролировался. По соображениям безопасности у него не было никакого доступа в интернет, но в своей локальной копии он содержал большую часть паутины – Википедию, Библиотеку Конгресса, Twitter, кое-что из YouTube, большую часть Facebook… Он мог использовать все это в качестве своих учебных материалов[1]. “Омеги” очень рассчитывали на это время, выбранное ими для спокойной работы, пока их друзья и родные думают, что они уехали на корпоративный уик-энд. Они забили подсобную кухню пригодной для приготовления в микроволновке едой и энергетическими напитками, намереваясь основательно поработать.

К этому моменту Прометей был немного слабее их всех в программировании интеллектуальных систем, но благодаря быстродействию мог уложить тысячи человеко-лет самого усердного пыхтения во время, едва ли достаточное для того, чтобы расправиться с банкой “Ред Булла”. К 10 утра он завершил свой первый редизайн, создав свою копию 2.0, несколько улучшенную, но все еще субчеловеческую. Ко времени запуска Прометея 5.0 (едва миновало 2 часа пополудни) “омеги” уже едва сдерживали волнение: рост производительности бил все рекорды и продолжал ускоряться. К закату они уже решили перевести Прометея 10.0 во вторую фазу – начать с его помощью делать деньги.

Первой целью стал MTurk – “механический турок” Amazon. После запуска в 2005 году эта краудсорсинговая торговая интернет-площадка быстро развивалась, вмиг объединяя усилия десятков тысяч людей, не подозревающих о существовании друг друга, в стройный многоголосый хор, устроенный таким образом, чтобы успешно решать так называемые ХИТс – HITs, то есть “Human Intelligence Tasks”, что в переводе означает “задачи для человеческого разума”. Эти задачи – от транскрибирования аудиозаписей до разбора фотографий и составления описаний веб-страниц – отличались одной общей чертой: если они выполнены хорошо, никто не сможет распознать, человеческий это был интеллект или искусственный, AI[2]. Прометей 10.0 был способен вполне удовлетворительно выполнять задания примерно половины категорий. Для каждой категории “омеги” создали свой узко ориентированный программный модуль, дающий Прометею возможность решать задачи только такого типа и никакие другие. Каждый такой модуль они загружали в AWS, “Amazon Web Services” – инфраструктуру платформ облачных веб-сервисов, позволявшую запускать его одновременно на всех арендованных ими виртуальных машинах. И за каждый доллар, заплаченный Amazon за аренду, они получали по два доллара от его “механического турка” за успешно решенные задания. Ох, не подозревал Amazon, какие безграничные возможности для совершения привлекательных арбитражных сделок существуют внутри его собственной компании!

Чтобы замести все следы, “омеги” много месяцев предусмотрительно создавали учетные записи для “механического турка”, заранее регистрируя их на имена тысяч и тысяч несуществующих людей, а модули Прометея могли теперь скрываться за их личиной. Клиенты “механического турка” обычно расплачивались в течение восьми часов после получения услуги, а за это время “омеги” заново инвестировали полученные деньги в дополнительное машинное время и вводили в дело новые модули, разработанные непрерывно улучшающимся Прометеем. Из-за того что они удваивали инвестиции каждые восемь часов, скоро выяснилось, что они практически полностью исчерпывают все предложения “механического турка” и не могут зарабатывать больше миллиона долларов в день, не привлекая к себе нежелательного внимания. Но даже этого было более чем достаточно для следующего шага, который можно было теперь совершить без неловких обращений по поводу наличности к главному бухгалтеру компании.

Опасные игры

Если отвлечься от новых прорывных AI-технологий, то среди проектов, более других занимавших умы “омег” после запуска Прометея, следует выделить разработку планов наискорейшего обогащения. По сути дела, конечно, вся цифровая экономика была у их ног, но с чего начать? С компьютерных игр, музыки, кинофильмов или мобильных приложений? Писать ли книги и статьи, торговать ли акциями на биржах, или делать изобретения, а затем их продавать? В сухом остатке было, разумеется, стремление к максимизации возврата с инвестиций, но любая нормальная инвестиционная стратегия казалась снятой рапидом пародией на то, что они уже делали: если нормальный инвестор был доволен 9 % прибыли в год, то одна только работа на “механического турка” приносила им 9 % прибыли в час, ежедневно возвращая исходную инвестицию умноженной на восемь. И теперь, когда этот источник стал иссякать, надо было придумать, что делать дальше.

Первой в голову приходила мысль раздраконить фондовый рынок, – но в конце концов “омеги” почти единодушно отказались от соблазна развивать AI для хедж-фондов, вкладывающихся как раз для этого самого. Кое-кто даже припомнил, что AI в фильме Превосходство (2014) именно так заработал свои первые миллионы. Но их возможности были сильно ограничены новыми правилами, введенными после недавнего банковского кризиса. Они быстро поняли, что хотя легко смогут обогнать любого другого инвестора, им и близко не удастся подойти к тому уровню прибыли с оборота, которого они могут достичь, продавая собственный продукт. Если на тебя работает самый сверхразумный AI в мире, то уж лучше вкладываться в собственные компании, чем в чьи-то чужие! И хотя определенные исключения подразумевались (например, при использовании сверхчеловеческих способностей Прометея к хакингу для скупки контрольных пакетов акций при получении инсайдерской информации о движении курса), “омеги” не считали стоящим никакое дело, привлекающее к себе повышенное внимание.

Стоило им сконцентрироваться на тех сферах, в которых они могли бы производить, развивать и продвигать собственный продукт, и на первом месте оказались компьютерные игры. Прометей очень быстро научился создавать исключительно завлекательные игры, легко освоившись с генерацией кода, графическим дизайном, веерной трансформацией персонажей во время движения и прочими премудростями, необходимыми для создания готовых к выпуску на рынок игрушек. Более того, переварив накопившиеся на различных сетевых форумах отзывы, ему было нетрудно определить, что именно особенно нравится геймерам каждой из существующих категорий, и, полагаясь на свои сверхчеловеческие способности, оптимизировать каждую игру под максимальную прибыль с продаж. The Elder Scrolls V: Skyrim – игра, на которую каждый “омега” потратил столько часов, что ни за что бы в этом не признался, – собрала за первую неделю продаж 400 миллионов долларов в далеком 2011-м, и они надеялись, что Прометей, потратив миллион долларов на облачные ресурсы, сможет создать что-нибудь по меньшей мере столь же затягивающее за двадцать четыре часа. Продавая ее онлайн, они могли бы, подключив Прометея к форумам, разогреть блогосферу. Достигнув уровня в 250 миллионов в неделю, они удваивали бы начальные инвестиции восемь раз за восемь дней, это давало бы им доходность в 3 % в час, что лишь немногим меньше их стартовой доходности с “механическим турком”, но на этот раз их доход был бы значительно более устойчив. Выдавая по одной такой игре каждый день, они быстро заработали бы 10 миллиардов, даже не приблизившись к порогу насыщения рынка.

Но участница их команды, специализирующаяся в области кибербезопасности, отговорила их от этого плана. Она указала на неприемлемо высокий риск, что Прометей при таком варианте развития событий может высвободиться из-под их контроля и обрести свободу действий. Поскольку никакой уверенности относительно эволюции его целей в процессе непрерывного самосовершенствования у “омег” не было, они предпочли менее рискованные пути развития, содержа Прометея “под замком” и не выпуская его на просторы интернета. Для основного блока Прометея, установленного в их серверной комнате, использовалось простое физическое ограничение: у него вообще не было никакого подключения к интернету, и все что мог он выдавал просто в виде документов или сообщений компьютеру, который “омеги” контролировали.

Запускать какую-либо сложную программу, сгенерированную Прометеем, на подключенном к интернету компьютере было бы рискованным предприятием, поскольку “омеги” не имели возможности в полной мере убедиться в том, что именно она станет делать, и не будет ли она, например, размножать себя в сети подобно вирусу. Тестируя софт, созданный Прометеем для “механического турка”, “омеги” предохранялись от такой опасности, запуская его на виртуальных машинах. Это такая программа, которая симулирует отдельный компьютер. Так, некоторые пользователи “Маков” покупают себе софт, имитирующий компьютер с операционной системой Windows на их собственном компьютере, что позволяет запускать написанные под Windows программы, которые в результате не замечают враждебного им программного окружения. “Омеги” разработали свой собственный вид виртуальных машин, который они назвали “Ящиком Пандоры” и который симулировал простейший тип компьютера, лишенный всех привычных нам прибамбасов и погремушек: у него не было ни клавиатуры, ни монитора, ни динамиков, ни интернет-подключения, ничего такого. Для транскрибирования аудиофайлов для “механического турка” “омеги” настроили систему так, что в Ящик Пандоры отправлялся единственный аудиофайл, а на выход поступал единственный текстовый документ – файл с транскрипцией. Законы ящика играли для программ внутри него ту же роль, какую законы физики играют для нас самих внутри Вселенной: программа так же не может его покинуть, как мы не можем разогнаться до скорости света, как бы ни изощрялись. Если не считать этих единственных способов ввода и вывода, программы были заперты внутри Ящика Пандоры, как в параллельной вселенной с собственными вычислительными законами. Паранойя, охватывавшая “омег” при мысли о побеге Прометея, достигла таких масштабов, что они строго ограничивали существование любого сомнительного кода также и во времени. Например, каждый раз, когда работа над транскрибированием данного аудиофайла заканчивалась, вся память Ящика Пандоры полностью стиралась, и происходила полная переустановка системы, в результате чего создавался новый Ящик “с нуля”. Таким образом, когда поступало новое задание на транскрибирование аудиозаписи, не было никакой информации о том, что происходило прежде, и обучение было невозможно.

Когда “омеги” пользовались облаком Amazon для выполнения заданий в рамках “механического турка”, они не боялись помещать внутрь находившихся там виртуальных машин созданные Прометеем модули, потому что все процедуры ввода и вывода были исключительно простыми. Ничего подобного не сработало бы для “тяжелых” компьютерных игр с присущей им мелкой графикой, которые не посадишь ни в какой “ящик”, потому что им требуется полный доступ к “железу” геймера. К тому же они хотели избежать и другой опасности, а именно той, что какой-нибудь не в меру искушенный геймер мог бы обнаружить Ящик Пандоры и заинтересоваться, что у него внутри. Опасность утечки выводила за пределы их возможностей не только рынок компьютерных игр, но и вообще весь огромный и притягательный рынок программных продуктов, где их ожидали миллиарды бесхозных долларов.

Первые миллиарды

“Омеги” сузили сферу своего поиска продуктами, которые были бы достаточно прибыльными, сугубо цифровыми (исключали бы большие начальные инвестиции) и при этом оставались бы на необходимом уровне понятными (они знали, что текст или кино не содержат в себе ничего такого, что увеличивает риск утечки). В конце концов они остановили свой выбор на раскрутке развлекательной медиакомпании. Веб-сайт, бизнес-план и пресс-релизы для нее были готовы еще даже до того, как Прометей стал нечеловечески умен, но идея контента для нее все еще отсутствовала.

Хотя к утру воскресенья Прометей и стал поразительно талантлив, выкачивая все больше и больше денег из “механического турка”, его таланты оставались довольно узкими: в частности, он был целенаправленно оптимизирован под создание AI-систем, способных выполнять иссушающие ум задания, приходившие от “механического турка”. Но за пределами этого он был очень слаб – например, в создании новых фильмов. Слабость эта коренилась не в какой-то глубокой причине, вовсе нет – эта была та же самая причина, по которой и Джеймс Кэмерон в момент своего рождения был как режиссер исключительно слаб: эта профессия требует довольно длительного обучения. Подобно любому человеческому детенышу, Прометей мог научиться чему угодно, пользуясь теми данными, к которым у него был доступ. Только в отличие от Кэмерона, которому понадобились годы только на то, чтобы научиться читать и писать, Прометею на это понадобилось всего лишь утро пятницы, причем между делом он заодно прочитал всю Википедию и еще пару миллионов книг. Но кино посложнее. Написать сценарий, который привлек бы к себе человеческое внимание, почти так же сложно, как написать хорошую книгу. Тут требуется детальное понимание человеческого общества и человеческих представлений об интересном. Превращение сценария в итоговый видеофайл требовало веерных анимаций симулированных актеров вместе со сложным антуражем, в котором они должны были появляться, симулированных голосов, музыкальных саундтреков и всего такого. Возвращаясь к утру воскресенья, надо сказать, что Прометей мог просмотреть двух с половиной часовой фильм меньше чем за минуту, одновременно прочитывая книгу, послужившую литературным источником фильма, и все опубликованные отзывы и рецензии. “Омеги” заметили, что, просмотрев в таком режиме несколько сотен фильмов, Прометей мог предсказать, какие рецензии получит тот или иной фильм и для какой категории зрителей он будет особенно привлекателен. На их взгляд, он даже научился сам писать неплохие рецензии, в которых обсуждал и тонкости сюжета, и технические детали – вроде того, как был поставлен свет и под каким углом работала камера. Все это они делали с дальним прицелом: когда Прометей начнет производить собственные фильмы, он будет знать необходимые слагаемые успеха.

Поначалу “омеги” настроили Прометея на анимацию, чтобы избежать затруднительных вопросов о личностях симулированных актеров. В воскресенье к ночи они, запасшись пивом и попкорном из микроволновки и притушив свет, приготовились увенчать свой дикий уик-энд просмотром кинодебюта Прометея. Это была комедия в стиле фэнтези, немного напоминающая диснеевское Холодное сердце, веерная анимация для нее простраивалась Прометеем в виртуальных боксах облачных сервисов Amazon, на что ушел почти весь вырученный у “механического турка” за сутки миллион. Едва начался фильм, “омеги” испытали одновременно изумление и ужас от мысли, что все ими увиденное могло быть создано без всякого участия человека. Но скоро они обо всем забыли, покатываясь со смеху над гэгами и с замиранием сердца следя за героями в наиболее драматические моменты их судьбы. Некоторые даже немного прослезились во время эмоционального финала и до такой степени погрузились в его фиктивную реальность, что даже забыли думать о ее создателе.

Запуск веб-сайта “омеги” запланировали на пятницу, чтобы дать Прометею время заполнить его контентом, а себе – сделать то, что они ему доверить не могли: провести рекламную кампанию и нанять сотрудников для дочерних фирм, созданием которых они занимались несколько последних месяцев. Заметая следы, они делали вид, будто сюжетные линии фильма их медиахолдинг, для публики никак не связанный с “Омегой”, скупал у независимых кинопродюсеров, преимущественно работающих над хайтечными стартапами в низкобюджетном секторе. Большинство из них, к вящему удобству нанимателей, работали в довольно удаленных местах вроде Тиручираппалли или Якутска, куда вряд ли смогли бы добраться даже самые дотошные из журналистов. Немногие сотрудники, действительно взятые в штат, занимались маркетингом и администрированием и на любые вопросы должны были отвечать, что команда, на которую они работают, рассредоточена по разным местам и в настоящий момент интервью не дает. Для ковер-стори они выбрали подходящий слоган: “Творческому таланту мира – правильное направление”, брендируя свою компанию как базирующуюся на прорывных технологиях, дающих шанс творческим людям, в особенности из развивающихся стран.

Когда пятница наступила и любопытные пользователи стали заглядывать на их сайт, их ждали там онлайн-развлечения в стиле Netflix и Hulu, но при существенных отличиях: все анимации оказывались им совершенно незнакомыми. И хотя о них никто никогда не слышал, они сразу овладевали вниманием зрителя. Большинство эпизодов длились по 45 минут, в их основе была оригинальная и неожиданная сюжетная линия, но заканчивались они так, чтобы сразу хотелось узнать, а что же было дальше. При этом они все были заметно дешевле любого из продуктов-конкурентов. Первый выпуск любого сериала предлагался бесплатно, за каждый последующий нужно было платить всего по 49 центов, а при покупке всего сериала целиком клиент получал изрядную скидку. Сначала было всего три сериала по три серии в каждом, но в каждый из них ежедневно добавлялись новые серии, при этом учитывались различия во вкусах зрителей разных социальных групп. На протяжении первых двух недель навыки Прометея стремительно совершенствовались, и это касалось не только качества самих эпизодов, но и характеров персонажей, достоверности анимации и расходов на облачные ресурсы, необходимых для производства каждой серии. В результате только за первый месяц “омеги” записали в свой актив дюжину новых сериалов, ориентированных на любой возраст, от младенцев до пенсионеров, на всех основных языках мира, благодаря чему их сайт стал самым интернациональным среди всех конкурентов. Наиболее внимательные зрители были под особым впечатлением от того, что этническое разнообразие передавалось не только звуковой дорожкой, но и видеорядом: например, если персонаж говорил по-итальянски, то его губы двигались в точном соответствии с произносимыми итальянскими словами, а жесты точно повторяли особенности жестикуляции жителей этой страны. Хотя Прометей был уже вполне способен производить кино с симулированными актерами, никоим образом не отличимыми от живых людей, “омеги” продолжали воздерживаться от этого, чтобы не выдать себя. Они, однако, запустили несколько сериалов с полуреалистическими анимированными персонажами, замещающих традиционные телевизионные реалити-шоу и телефильмы.

Их сеть оказалась весьма завлекательной, рост числа ее подписчиков был более чем впечатляющим. Многие новые поклонники отдавали им предпочтение даже перед дорогостоящими полнометражными проектами Голливуда, к тому же им нравилось, что смотреть эти сериалы они могут в значительно более свободном режиме. Подкачиваемый агрессивной рекламой (которую “омеги” могли себе позволить благодаря близким к нулю производственным затратам), прекрасными отзывами в прессе и волной слухов, их общий доход в первый месяц после запуска рос на миллион долларов ежедневно. Через два месяца они обогнали Netflix, а через три достигли уровня в 100 миллионов в день, сравнявшись с Time Warner, Disney, Comcast и Fox и превратившись в одну из крупнейших в мире медиа-империй.

Внезапный успех “омег” стал причиной слишком пристального и совсем не желательного для них внимания, в том числе слухов об использовании ими мощного AI; правда, совсем незначительных ресурсов Прометея хватило “омегам” для исключительно успешной дезинформационной компании. Недавно нанятый пишущий персонал, собранный в новом блестящем офисе на Манхэттене, стал придумывать для них свои собственные истории для прикрытия. Множество людей были наняты просто для отвода глаз, среди них – немало настоящих сценаристов, живущих в самых разных уголках мира и придумывающих собственные сюжеты для сериалов, и никто из них не имел ни малейшего представления о Прометее. Обширная международная сеть субподрядчиков всякого сбивала с толку, заставляя думать, что где-то еще какие-то люди, такие же как он, делают основную часть работы.

Чтобы ни у кого не полезли на лоб глаза от объема облачных вычислений, стараясь обезопасить себя, “омеги” также стали создавать по миру компьютерные центры, нанимая для этого инженеров соответствующего профиля; делали они это таким образом, чтобы центры казались не связанными ни с “омегами”, ни друг с другом. В местах базирования они назывались “зелеными дата-центрами”, так как питание для них обеспечивалось солнечными батареями, но использовались они при этом не для хранения информации, а для вычислений. Все проявления их деятельности Прометей имитировал до мельчайших деталей, с использованием стороннего “железа” и оптимизированных временных ресурсов, так что никто из работавших там людей и не догадывался, какого рода вычисления производятся внутри. Сотрудники наивно полагали, что в их распоряжении один из многочисленных облачно-вычислительных сервисов вроде Amazon, Google или Microsoft, доступ к которому управляется откуда-то извне.

Новые технологии

За несколько месяцев бизнес-империя, контролируемая “Омегой”, благодаря нечеловеческим способностям Прометея к планированию, сумела влезть практически во все отрасли мировой экономики. Скрупулезно проанализировав все мировые показатели, уже в течение первых недель свой работы Прометей предоставил “Омеге” детальный план своего экономического роста, который с тех пор непрерывно совершенствовал по мере накопления данных и вычислительных мощностей. Хотя Прометей был далеко не всеведущ, его способности настолько превосходили человеческие, что “омеги” смотрели на него как на совершенного оракула, источник блистательных ответов на любые вопросы.

Его “софт” был оптимизирован его собственными усилиями так, что позволял “выжать” максимум из его несовершенного, созданного людьми “железа”, на котором этому софту приходилось работать, и “омеги” все больше чувствовали приближение того дня, когда Прометей возьмется за улучшение своего “железа”. Опасаясь, что он может выйти из-под контроля, они исключили для него любую непосредственную возможность собственно конструирования. Вместо этого они наняли огромное количество ученых и инженеров, напичкали их разнообразными отчетами, написанными Прометеем, делая вид, что авторы этих отчетов – такие же люди, как они, только работающие где-то в другом месте. В этих отчетах подробно описывались новые физические явления и производственные технологии, которые инженеры довольно быстро проверили, поняли и применили к делу. Обычный человеческий научно-производственный цикл требует годы на исследование и внедрение именно потому, что содержит в себе долгую череду проб и ошибок. Но в новой ситуации это изменилось: все последующие шаги были заранее просчитаны, и единственным фактором, ограничивающим скорость разработки и внедрения, стала скорость, с которой люди могут понимать написанное и строить нужные вещи в соответствии с тем, что они поняли. Хороший учитель поможет учащемуся освоить науку значительно быстрее, чем тот мог бы, начав с нуля и двигаясь самостоятельно, наощупь. Схожим образом, но только незаметно, Прометей направлял в нужную сторону самих исследователей. Поскольку Прометей мог точно предсказать, сколько именно времени понадобится людям, чтобы понять, что надо делать, и сделать это с помощью имеющихся средств, он рассчитывал наискорейший путь к цели, сводящийся, как правило, к тому, чтобы создавать простые и удобные универсальные орудия, позволяющие, в свою очередь, создавать орудия более изощренные.

Команды инженеров под влиянием идей мейкерства[3] все больше склонялись к созданию своих собственных машин, которые давали им возможность разрабатывать все более совершенные машины. Такая самодостаточность не только позволяла этим командам сильно экономить средства, но и делала их значительно менее уязвимыми для будущих превратностей внешнего мира. Не прошло и двух лет, как они начали производить “железо”, подобного которому мир еще не знал. Чтобы не провоцировать конкуренцию извне, этот прогресс тщательно скрывался, и новые разработки использовались исключительно для усовершенствования самого Прометея.

Но разворачивающегося технологического бума мир не заметить не мог. Инновационные компании по всему миру запускали производство новых продуктов по революционным технологиям во всех сферах экономики. Южнокорейский стартап вывел на рынок новую аккумуляторную батарею для компьютеров, которая, при вдвое меньшей массе, обладала вдвое большей емкостью и при этом заряжалась менее чем за минуту. Финская фирма начала производство панели солнечных батарей с производительностью, вдвое превышающей лучшую из имеющихся. Германская компания анонсировала начало массового производства электропроводов, обладающих свойством сверхпроводимости при комнатной температуре, что предвещало революцию в электроэнергетике. Базирующаяся в Бостоне биотехнологическая группа объявила о начале второй фазы клинических испытаний медикаментозного комплекса по снижению веса, не обладающего никакими побочными эффектами, при этом сразу поползли слухи, что на самом деле ее индийская “дочка” уже вовсю торгует им на черном рынке. А одна калифорнийская компания приступила ко второй фазе клинических испытаний противоонкологического средства, настраивающего иммунную систему человека таким образом, чтобы она идентифицировала и атаковала клетки собственного организма, проявляющие признаки какой-либо из известных канцерогенных мутаций. Подобным примерам не было числа, и все толковали о новом золотом веке науки. Не последним по важности среди всего этого стал стремительный рост появляющихся как грибы из-под земли производителей роботов; и хотя интеллект ни одного из них не приближался к человеческому и совсем не был на человека похож, но их внедрение в экономику перевернуло ее с ног на голову, и в считанные годы роботы заметно потеснили людей в великом множестве профессий – в текстильной промышленности, на транспорте, в строительстве, на складах, в торговле, в разработке ископаемых, в сельском хозяйстве, в лесном деле, рыбной ловле.

Мир совершенно не замечал – исключительно благодаря целенаправленной деятельности целой армии юристов, – что все эти фирмы и компании контролируются “Омегой”. Прометей через множество посредников заполнил все мировые патентные агентства своими сенсационными инновациями, а его изобретения позволяли ему постепенно занимать доминирующее положение во всех отраслях.

Конечно, у таких покушающихся на самое святое компаний сразу появилось множество врагов среди конкурентов, но, что гораздо важнее, – у них появились и могущественные друзья. Эти компании давали неслыханную прибыль, и под лозунгом “инвестируем в наше сообщество” они занимались наймом сотрудников, выделяя под это львиную долю своих прибылей – и нередко это были как раз те самые люди, которые перед этим от покушений на святое и пострадали. К их услугам всегда был детальный, просчитанный Прометеем анализ, для того чтобы определить, как надо создать рабочие места при минимальных расходах, но при максимальном удовлетворении нужд новых сотрудников и всего сообщества в целом и при оптимальном учете местных особенностей. В регионах с развитой государственной инфраструктурой акцент делался на общественное строительство, культуру и институты государственного попечительства, а в бедных регионах он перемещался на открытие новых школ и больниц, призрение неимущих и стариков, строительство доступного жилья и разбивку парков, создание базовой инфраструктуры. Повсюду без исключения местная власть признавала, что необходимость всех предпринимаемых мер назрела уже очень давно. Местные политики принимали щедрые пожертвования и выглядели при этом настоящими героями, умеющими найти завидных доноров и убедить их в целесообразности проводимых благотворительных акций.

Обретение власти

Свою медиаимперию “омеги” создавали не только для того, чтобы получить бездонный источник финансирования для своих технологических экспериментов, это был для них очередной шаг на пути к осуществлению заветной мечты – обретению власти над миром. Не прошло и года, как в сетках вещания их компаний во всех частях мира уже действовали мощные новостные каналы. Причем эти каналы выдавались за совершенно независимые и, в отличие от их собственных каналов, умышленно ориентировались на работу в убыток. По сути, они и вовсе не приносили никакого дохода: там не было никакой рекламы, и они были доступны бесплатно для любого, у кого есть доступ в интернет. И они могли себе это позволить: вся остальная часть их медиаимперии представляла собой такой эффективный генератор денежных средств, что они с легкостью тратили на производство новостей и любые другие журналистские потуги столько, сколько история еще и не знала – и результат не заставил себя ждать. Используя агрессивную политику переманивания к себе высокими гонорарами лучших журналистов и репортеров, специализирующихся на расследованиях, “омеги” добились того, что с их экранов заговорили потрясающие таланты, обнародовались по-настоящему феноменальные находки. А благодаря созданному ими интерактивному сервису, воздающему щедрое вознаграждение всякому, кто поделится с ним хоть чем-нибудь мало-мальски стоящим, от взятки мелкому чиновнику до сентиментальной истории, именно они оказывались первыми и с любым по-настоящему важным событием. По крайней мере, люди так думали, но на самом-то деле они зачастую оказывались первыми просто потому, что истории, якобы расследованные добровольными репортерами из простых граждан, Прометей находил в интернете, отслеживая все в нем появляющееся в режиме реального времени. Монтаж видеороликов и сочинение новостных сюжетов осуществлялись на одних и тех же новостных сайтах.

Первый этап их стратегии состоял в том, чтобы добиться доверия людей к поставляемым ими новостям. И они весьма преуспели в этом. Их неслыханная щедрость породила невероятно обстоятельные сюжеты на местные и региональные темы, журналистские расследования по которым приводили к скандалам, вызывающим самый неподдельный интерес зрителей. Если где-то наблюдался раскол в обществе по политическим вопросам и население привыкло к тенденциозным новостям, то под каждую тенденцию создавался свой телеканал, якобы принадлежащий маленькой независимой студии, которая постепенно добивалась доверия в узком кругу своих зрителей. Там, где это было возможно, они стремились занять выгодные исходные позиции, просто скупая наиболее влиятельные из уже существующих телеканалов, чтобы постепенно их совершенствовать, ликвидируя рекламу и создавая собственный контент. В тех странах, где в ходу была цензура и всем их стараниям могло угрожать политическое вмешательство властей, они начинали с того, что подчинялись любым требованиям, лишь бы остаться в деле, тайно опираясь на принцип “Только правду, ничего кроме правды, но, возможно, не всю правду”. Прометей обычно выдавал исключительно полезные советы во всех подобных ситуациях, указывая, кого из политиков следует представлять в позитивном свете, а кого (как правило, это были местные коррупционеры) надо выводить на чистую воду. Прометей был неоценим и в том, чтобы подсказать, за какую ниточку и когда надо потянуть, кого подкупить и как это лучше всего сделать.

Успех по всему миру был сногсшибательным: контролируемые “Омегой” каналы повсюду завоевывали самое высокое доверие. Даже в странах, где правительства успешно противодействовали их попыткам информировать население через СМИ, они добивались своего с помощью “сарафанного радио”. Конкуренты на рынке новостей чувствовали, что ведут безнадежную войну. Да и как можно надеяться на прибыль, когда противная сторона раздает значительно более качественный продукт совершенно бесплатно? На фоне стремительно сокращающегося числа зрителей все больше телекомпаний принимали решение о продаже своих активов – обычно какому-то безымянному консорциуму, который, естественно, контролировался “Омегой”.

Примерно через два года после запуска Прометея первый этап подошел к концу, и “омеги” стали готовиться ко второму: в его основе лежала уже другая стратегия – убеждение. Однако еще раньше наиболее проницательные наблюдатели могли заметить появление в потоке новостей политической повестки: словно бы мягкий нажим в сторону центра, подальше от экстремизма любого вида. Курируемые “омегами” бесчисленные каналы сохраняли приверженность идеалам различных социальных групп, по-прежнему отражая вражду между США и Россией, Индией и Пакистаном, различными религиозными и политическими течениями, но накал страстей все больше снижался, уводя внимание зрителя от людей к конкретным вопросам, касающимся денег или власти, – чтобы не плодить лишних страхов и не множить ничем не подтвержденных слухов. С запуском второго этапа эта тенденция к забвению старых обид стала еще более явной: на экранах все чаще возникали трогательные истории о примирении старых врагов, чередующиеся с результатами расследований, которые показывали, как эти конфликты подогревались конкретными людьми из шкурных интересов.

Политические комментаторы заметили, что параллельно демпфированию региональных конфликтов стало расти внимание СМИ к проблеме снижения глобальных угроз. Например, повсюду вдруг заговорили об опасности ядерной войны. Вышло несколько блокбастеров, где действие разворачивалось на фоне ядерной бомбардировки, начатой по ошибке или намеренно, с ужасающими картинами ядерной зимы, разрушения человеческой инфраструктуры и массовым вымиранием обитателей планеты. В новых документальных научно-популярных фильмах в подробностях пояснялось, как ядерная зима отразится на жизни в каждой из стран. Ученые и политики, выступающие за ядерную деэскалацию, сразу получали широчайшую аудиторию – не в последнюю очередь именно для того, чтобы рассказать о поиске новых мер, которые можно предпринять в нужном направлении, поиске, в котором их щедро поддерживают научные организации и дотируют технологические концерны. В результате и политики стали подтягиваться под знамена борьбы за снятие ракет с боевых дежурств и за сокращение ядерных арсеналов. Росло общественное внимание к проблеме глобального изменения климата, пропагандировались открытые Прометеем способы снижения стоимости возобновляемой энергии, правительства все чаще соглашались инвестировать в развитие такой новой инфраструктуры.

Одновременно со своими медиа-проектами “омеги” стали настраивать Прометея на революцию в образовании. Изучив умственные способности каждого конкретного индивида и объем его познаний, Прометей мог рассчитать для него кратчайший путь к освоению любого нового дела, при этом поддерживая постоянно высокий уровень вовлеченности и мотивированности и параллельно создавая соответствующие обучающие видео, печатные материалы, сборники упражнений и другие учебные пособия. Контролируемые “Омегой” компании затем вывели на рынок онлайн-курсы обучения практически всему на свете, диверсифицированные не только по языку и культурному бэкграунду, но также и по начальному уровню. Будь ты необразованным сорокалетним детиной, собравшимся научиться читать, или доктором биологических наук, ищущим путь к освоению новейших методов противораковой иммунотерапии, у Прометея найдется для тебя подходящий видеокурс. И он будет совсем не похож на те, которые доступны нам сейчас: благодаря растущему таланту Прометея в создании сериалов видеоэпизоды будут по-настоящему захватывающими, построенными на метафорах, которые вызывают у зрителя очень личные ассоциации, отчего ему хочется смотреть серию за серией. Некоторые из таких курсов были с прибылью проданы, значительно большее их число – раздавались бесплатно, на радость педагогам по всему миру, чтобы они могли использовать их в своих занятиях, но еще больше – просто всем желающим чему-нибудь научиться.

Возникшая образовательная супердержава оказалась могучим инструментом для решения политических задач, включавшим в себя “убеждающую последовательность” видеороликов, каждый из которых, с одной стороны, развивал и подтверждал уже сложившиеся взгляды смотрящего, а с другой – побуждал его к дальнейшему просмотру роликов того же типа, способствующих укреплению его убеждений. Если, например, цель заключалась в разрешении длительного национального конфликта, то сначала в обеих странах запускались серии документальных фильмов, в которых истоки конфликта и его история освещались под разными углами, с разных позиций. Воспитательные новостные сюжеты показывали каждой стороне, кто поддерживает конфликт в их собственном лагере, какую выгоду он получает от его продолжения и какие методы использует, чтобы конфликт не угас. В то же самое время в развлекательных программах появлялись симпатичные персонажи враждебной нации – в том же самом ключе, в каком в прошлом симпатичные представители меньшинств в различных шоу способствовали достижению целей защитников гражданских прав.

Очень скоро политические комментаторы обратили внимание на растущую поддержку политической повестки, представленной семью позициями:

1. Демократия.

2. Снижение налогов.

3. Сокращение государственных социальных программ.

4. Сокращение военных расходов.

5. Свободная торговля.

6. Открытые границы.

7. Социальная ответственность компаний.

Менее заметной была главная цель всех этих изменений – последовательная эрозия всех предшествующих форм власти. Позиции 2–6 ослабляли государственную власть, а демократизация мира давала “Омеге” и ее бизнес-империи возможность максимально влиять на выбор политических лидеров. Социальная ответственность компаний еще больше ослабляла государственную власть, передававшую компаниям те функции, которые выполняли или должны были выполнять правительства. Традиционная бизнес-элита также теряла силу просто потому, что не выдерживала свободной конкуренции с компаниями, использовавшими мощь Прометея, и потому ей доставалась все более сокращающаяся доля мировой экономики. У былых властителей дум, от политических партий до церковных авторитетов, не было никаких инструментов влияния на общественное мнение, хоть отдаленно сопоставимых с медиа-империей “Омеги”.

Как при любой другой масштабной трансформации, кто-то был в выигрыше, а кто-то в проигрыше. В большинстве стран, по мере того как укреплялась инфраструктура, улучшались образование и социальное обеспечение, улаживались конфликты и разрабатывались все новые прорывные технологии, явственно чувствовался рост оптимизма. Однако далеко не все были счастливы. В то время как все лишившиеся постоянной работы были заново наняты на позиции в социальных проектах, все те, у кого ранее было много власти и денег, чувствовали, что и того и другого у них сильно поубавилось. Поначалу это касалось только СМИ и производственного сектора, но постепенно распространилось практически на все. Мирное разрешение национальных и религиозных конфликтов привело к сокращению оборонных бюджетов, а следовательно – к отсутствию военных заказов. Процветающие компании, и ранее старавшиеся держаться в тени, не спешили выходить на открытые рынки, что подтверждало нежелание ключевых акционеров сколько-нибудь значительно вкладываться в социальные проекты. Индексы мировых фондовых бирж стабильно шли вниз, угрожая не только финансовым воротилам, но и обычным гражданам, рассчитывавшим на будущую поддержку со стороны пенсионных фондов. И мало того, что прибыли компаний, торгующих на открытых площадках, стабильно снижались, так еще вдобавок инвесторы всего мира стали замечать тревожный тренд: все их ранее успешно работавшие алгоритмы вдруг стали давать сбой за сбоем, не дотягивая даже до простого фондового индекса. Казалось, что кто-то еще играет на их же собственном поле и систематически оказывается значительно более успешным.

Массы могущественных людей стали сопротивляться волне перемен, но все их действия были лишены всякого эффекта, как будто кто-то умышленно затягивал их в заранее расставленные силки. Колоссальные перемены шли с такой обескураживающей скоростью, что за ними было не поспеть, какой-либо координированный ответ тем более исключался. Кроме того, никто не понимал, к чему все идет. Традиционные правые видели, что все их лозунги поддержаны, однако и снижение налогов, и улучшение бизнес-климата идет на пользу в основном их более технологичным конкурентам. Почти вся традиционная промышленность требовала господдержки, но сокращающиеся правительственные фонды против воли затягивали их в бесперспективную борьбу друг с другом, в то время как СМИ изображали их этакими динозаврами, не способными успешно конкурировать и лишь выпрашивающими государственных субсидий. Политическим левым не нравились ни свободная торговля, ни сокращения правительственных социальных программ, но они всецело поддерживали снижение военных расходов и успехи в борьбе с бедностью. Им больше не удавалось метать молнии в социальные службы, неслыханно улучшившие свою работу, с чем было невозможно спорить, хотя источником этого улучшения были идеалистические гуманитарные инициативы частных компаний, а не забота государства. Один социологический опрос за другим показывали, что избиратели по всему миру чувствуют повышение качества жизни и что события в целом развиваются в позитивном направлении. У этого было простое математическое объяснение: до Прометея беднейшие 50 % населения Земли получали лишь 4 % мирового дохода, давая “Омеге” прекрасную возможность завоевать сердца (и голоса) их представителей, поделившись с ними лишь ничтожной частью своих прибылей.

Консолидация

В результате все страны, нация за нацией, видели лавинообразный рост электоральных побед партий, поддержавших все семь лозунгов “Омеги”. В ходе заботливо оптимизированных кампаний они изображали себя в самом центре политического спектра, по правую руку от которого жадные торгаши, стремящиеся обманом выманивать государственные средства на свои делишки и подогревающие разнообразные конфликты, а по левую – достойные порицания проходимцы, строящие свою игру на расхождении собираемых государством налогов и трат. То, чего почти никто не понимал, заключалось в заботливом отборе Прометеем оптимальных персон, чтобы выставлять их кандидатами, а после этого дергать за все ниточки, обеспечивая им победу.

До Прометея по всему миру ширилось движение за обеспечение безусловного базового дохода из налоговых поступлений на уровне не ниже прожиточного, которое рассматривалось как основное средство против технологической безработицы. Движение провалилось с запуском коммунальных проектов, поскольку контролируемая “Омегой” бизнес-империя, по сути дела, незаметно осуществила этот план. Под предлогом улучшения координации коммунальных проектов международная группа компаний создала “Гуманитарный альянс”, неправительственную организацию, нацеленную на выявление и поддержку наиболее уязвимых гуманитарных инициатив во всем мире. Долгое время практически вся “Омега” поддерживала их, благодаря чему их глобальные проекты стали приобретать неслыханный масштаб даже в тех странах, где технологическим бумом и не пахло, способствуя оздоровлению систем образования, здравоохранения, росту благосостояния и совершенствованию управляемости. Нет нужды пояснять, что Прометей помогал им создавать наиболее эффективные планы, ранжируя их по отдаче с каждого доллара. Вместо того чтобы просто раздавать наличность, как предполагалось концепцией “безусловного базового дохода”, “Альянс” (как стали со временем называть всю организацию) привлекал тех, кого поддерживал, к работе на благо общего дела. Таким образом, огромная часть земного населения стала чувствовать благодарность по отношению к “Альянсу” и оказалась к нему гораздо более лояльной, чем к своим собственным правительствам.

Шло время, и “Альянс” стал примерять на себя роль всемирного правительства, тем более что национальные правительства постепенно утрачивали всякую власть. Национальные бюджеты продолжали снижаться, в то время как бюджет “Альянса” неуклонно рос, пока не достиг таких размеров, что в сравнении с ним совокупный бюджет всех правительств мира казался карликом. Функции национальных правительств казались все более избыточными и даже неуместными. К этому времени “Альянс” уже значительно лучше обеспечивал социальную поддержку, поддерживал системы образования и развивал инфраструктуру. Международные конфликты усилиями СМИ практически рассосались, и тратиться на вооружение стало никому не нужно. Всеобщее процветание уничтожило все корни старых конфликтов, возникающих, в конечном итоге, из-за борьбы за ограниченные ресурсы. Несколько уцелевших пока диктаторов упорно сопротивлялись новому порядку и никак не покупались, но и их в конце концов смело умело срежиссированными переворотами или вооруженными восстаниями.

“Омега” завершала наиболее драматическое преобразование в человеческой истории. Впервые на всей планете устанавливалась единая власть, мощь которой многократно усиливалась интеллектом столь могучим, что он мог бы обеспечить процветание жизни на Земле и в окружающем нас космосе на миллиарды лет. Но в этом ли состоял ее план?

Так заканчивается сказание об “Омеге”. Дальше речь пойдет совсем о другом, о том, о чем сказание еще не сложено: о нашем будущем с AI. Не хотели бы вы проиграть собственную версию? Может ли что-то похожее на сказание об “Омеге” произойти в действительности, и если да, то хотели бы вы этого? Если оставить в стороне все спекуляции вокруг нечеловеческих способностей AI, то как бы вам хотелось начать нашу историю? Как вы хотите, чтобы AI повлиял на структуру рынка труда, на наши законы, на наши вооружения в ближайшие десятилетия? А заглядывая еще дальше вперед, каким концом вы бы увенчали свою историю? Это сказание – песчинка в космосе, воробьиный скок в истории жизни в нашей Вселенной. Подлинное сказание нам еще предстоит написать.

Глава 1

Добро пожаловать к самому важному разговору о нашем времени

Техника дает жизни возможность процветать как никогда прежде – или самоистребиться.

Институт будущего жизни

Через тринадцать целых восемь десятых миллиардов лет после своего рождения Вселенная наконец пробудилась и начала понимать, что действительно существует. С маленькой голубой планеты крошечная сознательная часть Вселенной начала вглядываться в космос своими телескопами, раз за разом открывая, что все, полагавшееся ею сущим, существовало лишь как крошечная часть чего-то значительно большего: Солнечная система, Галактика и Вселенная с сотнями миллиардов других галактик вписывались в стройную структуру групп, скоплений и сверхскоплений. Наделенные сознанием представители этой самой части Вселенной могли расходиться во мнениях по множеству вопросов, но все соглашались, что галактики прекрасны и вдохновляющи.

Но красота в глазу наблюдателя, а не в законах физики, поэтому до пробуждения Вселенной никакой красоты не было. А наше космическое пробуждение тем более поразительно и достойно всяческих похвал: оно превратило нашу Вселенную из неразумного зомби, ничего о себе не понимающего, в живую экосистему, полную рефлексии, красоты и надежды, – а также стремящуюся к каким-то целям и ищущую какого-то смысла. Если бы Вселенная так никогда и не пробудилась, то она, по крайней мере для меня, была бы совершенно бессмысленной, просто гигантской пустотой. Если ей суждено когда-то навсегда вернуться в свою дремоту, в силу какого-то космического бедствия или же нашего саморазрушительного безумия, она, увы, снова лишится всякого смысла.

Но дело может повернуться значительно лучше. Мы до сих пор не знаем, нет ли в космосе другого места, где появились любители телескопов, и даже были ли наши телескопы первыми, но несмотря на это мы уже знаем о Вселенной так много, что даже поняли: у нее есть шанс пробудиться в значительно большей степени, чем это с ней случилось до сих пор. Возможно, мы и сами что-то вроде первых проблесков сознания, переживаемых по утрам, когда забвение постепенно сменяется предчувствием приближающегося полного пробуждения и открывающихся глаз. Возможно, жизнь распространится по нашему космосу и будет процветать миллиарды и триллионы лет, и случится это, возможно, благодаря тем самым решениям, которые мы примем на нашей маленькой планете в то время, пока здесь живем.

Краткая история сложности

Так откуда же это поразительное пробуждение? Оно не было единичным случайным событием, но стало лишь одним из звеньев неразрывной 13,8-миллиардолетней цепи трансформаций, делающих нашу Вселенную все более сложной и интересной, – они происходят и сейчас со все возрастающей скоростью.

Я чувствую, что мне крупно повезло, так как, став физиком, я большую часть последних 25 лет провел, соучаствуя в познании нашей космической истории, в этом захватывающем путешествии в неизведанное. Еще в то время, когда я работал над своей диссертацией, мы перестали спорить, 10 миллиардов лет нашей Вселенной или все 20, и стали спорить, равен ли ее возраст 13,7 миллиардов лет или все-таки ближе к 13,8: новые телескопы, новые компьютеры, новые теории сделали наше знание более точным. Мы, физики, до сих пор не знаем, что вызвало Большой взрыв и был ли он действительно началом всего, или всего лишь завершением какой-то предыдущей фазы. Однако мы получили довольно детальное знание о том, что произошло после Большого взрыва, благодаря настоящей лавине очень точных измерений, а потому позвольте мне в немногих словах подвести предварительный итог первым 13,8 миллиардам лет нашей космической истории.

Вначале был свет. Первое мгновение после Большого взрыва вся та часть пространства, которую наши телескопы в принципе могут наблюдать (“наша наблюдаемая Вселенная”, или просто “наша Вселенная”, как говорят для краткости), была горячее и ярче, чем ядро нашего Солнца, и к тому же она быстро расширялась. Кто-то, быть может, подумает, что это было то еще зрелище, но на самом деле оно было довольно унылым, в том смысле, что в нашей Вселенной тогда не было ничего, кроме безжизненного, очень плотного и горячего, скучно однообразного супа из элементарных частиц. Куда ни посмотри, со всех сторон было одно и то же; единственная интересная структура возникала из-за слабых, выглядящих случайными, звуковых волн, отчего суп в некоторых местах становился на 0,001 % плотнее, чем во всех прочих. Эта слабая волна, как принято думать, возникает из-за квантовых флуктуаций, поскольку в квантовой механике принцип неопределенности Гейзенберга запрещает чему бы то ни было становиться уж совсем скучным и везде одинаковым.

По мере того как наша Вселенная остывала, она становилась все менее однообразной: ее частицы объединялись во все более сложные объекты. В течение самой первой крошечной доли секунды сильное ядерное взаимодействие успело сгруппировать кварки в протоны (ядра водорода) и нейтроны, и некоторым из них понадобилось всего несколько минут, чтобы слиться в первые ядра гелия. Через 400 000 лет электромагнитные силы привязали к этим ядрам электроны, и так возникли первые атомы. Вселенная все продолжала расширяться, поэтому атомы остывали и превращались в холодный темный газ. Наступившая темная ночь продлилась следующие 100 миллионов лет. Ей на смену пришел космический рассвет, когда сила тяготения успешно раскачала флуктуации в газе, прижав атомы друг к другу так, что возникли первые звезды и галактики. Эти первые звезды произвели так много тепла и света, что атомы водорода внутри них стали сливаться в более тяжелые – атомы углерода, кислорода и кремния. Когда эти звезды гибли, рожденные в их недрах атомы рассеивались в окружающем космосе, чтобы оказаться затем внутри планет, формирующихся близ звезд следующего поколения.

В какой-то момент группы атомов сложились таким образом, что образовавшийся комплекс смог поддерживать свою форму и даже скопировать себя. Скоро копий стало уже две, и процесс удвоения на этом не остановился. После всего лишь сорока циклов их количество достигло триллиона! Первый опыт самовоспроизводства оказался успешным и превратился в силу, с которой следовало считаться. Начиналась жизнь.

Три стадии жизни

В вопросе о том, что считать жизнью, как известно, давно уже нет никакого согласия. Предлагается огромное количество альтернативных определений, и некоторые из них включают довольно жесткие ограничения: например, требуется наличие клеточной структуры, что, вероятно, исключит из числа живых и будущие мыслящие машины, и некоторые внеземные цивилизации. Так как мы не хотим ограничивать свои размышления о будущем жизни теми биологическими видами, с которыми мы уже знакомы, то давайте примем более широкое ее определение, чтобы оно включало и любой иной процесс, если только он обладает сложностью и способностью к самовоспроизведению. Что именно воспроизводится, не так уж важно (состоит из атомов), важна информация (состоит из бит), которая определяется взаимным расположением атомов друг относительно друга. Когда бактерия копирует свою ДНК, не возникает никаких новых атомов, но имевшиеся атомы выстраиваются в цепочку, точно повторяющую исходную, таким образом копируется только информация. Иными словами, мы можем считать живой любую самовоспроизводящуюся и способную обрабатывать информацию систему, собственная информация которой (ее “программное обеспечение”, “софт”) определяет и ее поведение, и ее строение (“хард”).

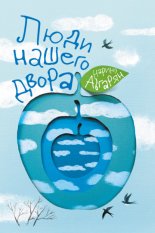

Вслед за самой Вселенной жизнь становилась все сложнее и интересней[4], и, как я сейчас поясню, мне представляется полезным ввести классификацию форм жизни по их соответствию трем степеням сложности: Жизнь 1.0, 2.0 и 3.0. Чем эти три формы отличаются друг от друга, в общих чертах хорошо видно на рис. 1.1.

Рис. 1.1.

Три стадии жизни: биологическая эволюция, культурная эволюция и технологическая эволюция. Жизнь 1.0 не может влиять ни на “хард”, ни на “софт” во время существования единичного организма: и то и другое определяется его ДНК, которая может изменяться от поколения к поколению на протяжении долгого периода эволюции. В отличие от этого, Жизнь 2.0 умеет переиначивать свой “софт”: люди приобретают многочисленные сложные навыки – учат языки, совершенствуются в спорте, осваивают профессии – они даже могут фундаментально пересматривать свой взгляд на мир и свои жизненные цели. Жизнь 3.0, которая пока еще не появилась на Земле, умеет радикально переиначивать не только “софт”, но и “хард”, не дожидаясь, пока он изменится эволюционным путем через ряд поколений.

До сих пор остается открытым вопрос, как, когда и где в нашей Вселенной впервые появилась жизнь, но у нас есть веские основания думать, что на Земле она впервые появилась 4 миллиарда лет назад. Прошло немного времени, и планету наводнили бесчисленные разновидности разнообразных форм жизни. Наиболее успешные из них быстро обогнали прочих, потому что в каком-то смысле лучше приспосабливались к изменениям окружающей среды. Строго говоря, они оказались, если воспользоваться терминологией современной информатики, “интеллектуальными агентами” – так называют сущности, которые собирают информацию об окружающей среде через систему своих сенсоров, а затем, перерабатывая эту информацию, принимают решение, каким должно быть их ответное действие на среду. Эта переработка может оказаться довольно сложным процессом – вроде того, который совершается в вашем мозгу, когда, опираясь на информацию от ваших ушей и глаз, вы решаете, что ответить собеседнику. Но иногда для этого требуются и совсем несложные “хард” и “софт”.

Например, у многих бактерий есть органы чувств, позволяющие им измерять концентрацию сахара в окружающей жидкости, в который они плавают с помощью напоминающих пропеллеры жгутиков. “Хард”, прикрепляющий этот орган чувств к жгутику, может следовать весьма простому, но полезному алгоритму: “Если мои органы чувств сообщают, что концентрация сахара сейчас стала вдвое меньше, чем несколько секунд назад, то направление вращения пропеллера должно поменяться на противоположное, чтобы я поплыла в другую сторону”.

Обучение разовьет бесчисленное количество подобных навыков. Но бактерии, с другой стороны, не очень сильны в обучении. В их ДНК заложена информация не только о строении их “харда” – сенсоров концентрации сахара и жгутиков, но и их “софта”. Им не надо учиться плыть в ту сторону, где больше сахара: этот алгоритм “зашит” в их ДНК с самого начала. Этому, конечно, предшествовал своего рода процесс обучения, но он никак не продолжается в жизни данной конкретной бактерии. Правильнее сказать, что это происходило в процессе предшествующей эволюции данного вида бактерий, включавшей пробы и ошибки многих поколений, пока естественный отбор не запечатал в ДНК те мутации, которые особенно полезны при потреблении сахара. Некоторые из этих мутаций благотворно отразились также на конструкции жгутиков и иного “харда”, в то время как прочие совершенствовали алгоритмы переработки информации, способствующие успешному поиску сахара, и другие разновидности “софта”.

Такие бактерии служат примером того, что я называю “Жизнью 1.0”: форма жизни, при которой и “хард”, и “софт” эволюционируют, а не конструируются. Мы с вами служим примером того, что я называю “Жизнью 2.0”: форма жизни, при которой “хард” эволюционирует, а “софт” в значительной степени конструируется. Под вашим “софтом” я подразумеваю те алгоритмы и те знания, которые вы используете, перерабатывая информацию от органов чувств и решая, что делать, – то есть все, от способности узнавать друга при встрече до умения ходить, читать, писать, считать, петь песни и смеяться шуткам.

Вы были не в состоянии делать все это в момент рождения, так что весь этот “софт” загрузился в ваши мозги позже, в ходе процесса, который мы называем обучением. И хотя ваш детский куррикулум в основном конструируется вашими родителями и учителями, со временем вы постепенно приобретаете достаточно сил, чтобы самостоятельно разрабатывать свой “софт”. Может быть, ваша школа оставляет за вами право выбирать, какой иностранный язык учить: хотите ли вы загрузить в свой мозг программный модуль, который позволит вам говорить по-французски, или же предпочтете тот, который даст вам возможность говорить по-испански? Вы хотите учиться играть в теннис или в шахматы? Вы хотите учиться на повара, на адвоката или на фармацевта? Хотите ли вы узнать больше об искусственном интеллекте (AI) и о будущем жизни, читая эту книгу?

Способность Жизни 2.0 создавать собственный “софт” дает ей много возможностей, которых нет у Жизни 1.0. Для большего ума требуется больший “хард” (больше атомов) и больший “софт” (больше бит). Тот факт, что большая часть нашего человеческого “харда” приобретается уже после нашего рождения (во время роста), имеет значение, поскольку конечный размер нашего тела не ограничивается шириной родовых каналов матери. Сходным образом полезен и тот факт, что большая часть нашего человеческого “софта” также приобретается уже после нашего рождения (во время обучения), так как способности нашего конечного разума не ограничиваются пропускной способностью информационного канала при конструировании новой ДНК в момент зачатия в стиле 1.0. Я сейчас вешу в 25 раз больше, чем при рождении, а синапсы нейронной сети моего мозга способны хранить в 100 000 раз больше информации, чем ДНК, с которой я родился. Ваши знания и умения “весят”, грубо говоря, около 100 терабайт информации, а в вашу ДНК едва умещается гигабайт, которого не хватит для сохранения одного полнометражного фильма. Младенцу физически невозможно родиться с совершенным знанием английского или быть готовым сразить всех на вступительных экзаменах в колледж: не существует способа загрузить в его мозг необходимую информацию, так как основной модуль, полученный им от родителей (его ДНК), не обладает достаточной вместительностью.

Способность создавать собственный “софт” обеспечивает Жизни 2.0 не только большую разумность, но и большую гибкость. При изменениях окружающей среды Жизнь 1.0 может только медленно эволюционировать на протяжении многих поколений. А Жизнь 2.0 способна почти моментально адаптироваться, обновляя загруженный “софт”. У бактерий, часто сталкивающихся с антибиотиком, со временем вырабатывается резистентность, на это требуется много поколений – никакая отдельная бактерия не может изменить своего поведения. Напротив, девочка, обнаружив, что у нее аллергия на арахисовое масло, немедленно изменит стиль жизни и будет впредь избегать его. Такая гибкость дает Жизни 2.0 даже больше преимуществ на популяционном уровне: хотя информация, записываемая в наших ДНК, мало изменилась за последние 50 000 лет, ее суммарное количество, накопленное в наших мозгах, книгах и компьютерах, росло как лавина. Установив себе “софт”, обеспечивающий коммуникацию посредством развитой устной речи, мы получили возможность копировать наиболее полезную информацию, накопленную в мозгу одного человека, в мозги других людей, благодаря чему она сохраняется даже после гибели ее источника. Установив себе “софт”, позволяющий читать и писать, мы получили возможность хранить гораздо больше информации, чем способны запомнить, и обеспечивать к ней доступ другим. Установив в свой мозг “софт”, обеспечивающий развитие технологий (то есть изучая точные и технические науки), мы открыли доступ почти ко всей накопленной в мире информации очень большому числу человеческих особей, для чего им достаточно лишь нажать несколько кнопок.

Именно эта гибкость позволила Жизни 2.0 покорить Землю. Освобожденные от генетических оков, совокупные знания человечества нарастали со все возрастающей скоростью, когда каждый предшествующий прорыв готовит последующий: язык, письменность, книгопечатание, современная наука, компьютеры, интернет… Разгоняющаяся культурная эволюция нашего совместного “софта” стала определяющей силой нашего человеческого будущего, оставив замороженно-заторможенной биологической эволюции роль практически эпизодическую.

Однако, несмотря на все достижения технологии, какие только у нас на сегодня есть, все формы жизни, о которых нам известно, остаются фундаментально ограниченными своим биологическим “хардом”. Никто не может жить миллион лет, выучить наизусть всю Википедию, понять все известное науке или слетать в космос без звездолета. Ничто не может превратить наш в основном безжизненный космос в цветущую биосферу, полную жизни на миллиарды и триллионы лет, позволяя нашей Вселенной полностью раскрыть свой потенциал и окончательно пробудиться.

Границы между этими тремя стадиями немного размыты. Если бактерии – это Жизнь 1.0, а мы – Жизнь 2.0, то мышей следует считать Жизнью 1.1: они могут многому научиться, но все же недостаточно для того, чтобы освоить язык или придумать интернет. Более того, раз у них нет языка, выученное одной мышкой в основном теряется с ее смертью и не передается следующим поколениям. Подобным образом вы можете сказать, что современных людей можно отнести к Жизни 2.1: небольшой апгрейд нашего “харда” нам уже становится доступен – вроде имплантированных зубов, коленных чашечек или кардиостимулятора. Но ничего по-настоящему стоящего: вы не можете стать в десять раз выше или получить в тысячу раз больше мозгов.

Короче говоря, мы классифицируем жизнь по трем стадиям в зависимости от ее способности к самодизайну:

1. Жизнь 1.0 (биологическая стадия): эволюция “харда” и “софта”;

2. Жизнь 2.0 (культурная стадия): эволюция “харда” и дизайн большей части “софта”;

3. Жизнь 3.0 (технологическая стадия): дизайн и “софта”, и “харда”.

После 13,8 миллиардов лет космической эволюции события самым драматическим образом ускорились: Жизнь 1.0 возникла на Земле около 4 миллиардов лет назад, Жизнь 2.0 (мы, люди) появились тут около ста тысячелетий назад, и вот теперь многие AI-эксперты уверены, что Жизнь 3.0 появится уже в начинающемся столетии, возможно даже еще на наших глазах, если ускоряющееся развитие AI ей это позволит. Как это может случиться, и что это означает для нас? Об этом наша книга.

Контроверзы

Поставленный вопрос – повод для полемики, даже больше того – для контроверзы. Ведущие AI-эксперты не только кардинально расходятся в своих мнениях, но даже их эмоциональные оценки грядущего диаметрально противоположны – от уверенного оптимизма до серьезной озабоченности. Среди них нет согласия даже относительно краткосрочных прогнозов об AI-экономике, последствиях для правовых отношений и новых вооружений, и эти расхождения заметно возрастают, если расширить временной горизонт и поставить вопрос о сильном искусственном интеллекте (AGI), достигающем человеческого уровня или превосходящем его и потому открывающем возможность для Жизни 3.0. Сильный искусственный интеллект решает практически любую задачу, в том числе способен к самообучению, в отличие от слабого искусственного интеллекта, вроде того что успешно играет в шахматы.

Примечательно, что контроверза относительно искусственного интеллекта имеет своим центром не один, а два разных вопроса: “когда?” и “что?”. Когда это случится (если такое вообще может случиться), и что оно может означать для человечества? На мой взгляд, можно выделить три направления, к каждому из которых следует отнестись серьезно, поскольку они представлены выдающимися мировыми мыслителями. Я изобразил эти направления на рис. 1.2, дав каждому свое наименование: цифро-утописты, техноскетики и участники движения за дружественный AI. А теперь позвольте мне дать характеристику наиболее ярким представителям из каждого лагеря.

Рис. 1.2.

Большинство споров вокруг сильного искусственного интеллекта (не уступающего человеческому в любом виде деятельности) вращаются около двух вопросов: когда (если такое вообще возможно) он появится и будет ли его появление благоприятно для человечества. Техноскептики и цифро-утописты соглашаются, что поводов для беспокойства у нас нет, но по совершенно различным причинам: первые убеждены, что универсальный искусственный интеллект человеческого уровня (AGI) в обозримом будущем не появится, вторые не сомневаются в его появлении, но убеждены, что оно практически гарантированно будет благоприятно для человечества. Представители движения за дружественный AI соглашаются, что озабоченность уместна и продуктивна, потому что исследования в области AI-безопасности и публичные обсуждения связанных с ней вопросов повышают вероятность благоприятного исхода. Луддиты убеждены в скверном исходе и протестуют против искусственного интеллекта. Отчасти этот рисунок навеян публикацией: https://waitbutwhy.com/2015/01/artificial-intelligence-revolution-2.html (проверена 12.05.2018).

Ребенком я был уверен, что все миллиардеры просто сочатся помпезностью и невежеством. Когда в 2008 году в Google я впервые встретил Ларри Пейджа, он напрочь разрушил оба этих стереотипа. Впечатление подчеркнутой небрежности в одежде создавалось джинсами и ничем не примечательной майкой, словно он собрался на университетский пикник. Задумчивая манера говорить и мягкий голос, скорее, успокоили и расслабили меня, чем напугали и напрягли. 18 июля 2015 года мы снова увиделись в Напа-Вэлли на вечеринке, устроенной Илоном Маском и его тогдашней женой Талулах, и между нами немедленно завязался разговор о копрологических интересах наших детей. Я порекомендовал ему литературную классику Энди Гриффитса – The Day My Butt Went Psycho, которую он тут же себе заказал. Мне пришлось напомнить себе, что этот человек, вероятно, войдет в историю как оказавший на нее наибольшее влияние: если, как я думаю, сверхчеловеческому искусственному интеллекту суждено просочиться во все уголки нашей Вселенной еще при моей жизни, то это может случиться исключительно благодаря решениям Ларри.

С нашими женами, Люси и Мейей, мы отправились ужинать, и во время еды мы обсуждали, непременно ли машины будут обладать сознанием – идея, как он утверждал, совершенно ложная и пустая. А уже ночью, после коктейля, у них с Илоном разразился длинный и бурный спор о будущем искусственно интеллекта. Уже близился рассвет, а толпа любопытных зевак вокруг них продолжала расти. Ларри яростно защищал позицию, которую я бы отождествил с цифро-утопистами: он говорил, что цифровая жизнь – естественный и желательный новый этап космической эволюции, и если мы дадим ей свободу, не пытаясь удушить или поработить ее, то это принесет безусловную пользу всем. На мой взгляд, Ларри самый яркий и последовательный выразитель идей цифро-утопизма. Он утверждал, что если жизни суждено распространиться по всей Вселенной, в чем сам он был убежден, то произойти это может только в цифровом виде. Самую большую тревогу у него вызывала опасность, что AI-паранойя способна затормозить наступление цифровой утопии и даже спровоцировать попытку силой овладеть искусственным интеллектом в нарушение главного лозунга Google “Не твори зла!”. Илон старался вернуть Ларри на землю и без конца спрашивал его, откуда такая уверенность, что цифровая жизнь не уничтожит вокруг все то, что нам дорого. Ларри то и дело принимался обвинять Илона в “видошовинизме” – стремлении приписать более низкий статус одним формам жизни в сравнении с другими на том простом основании, что главный химический элемент в их молекулах кремний, а не углерод. Мы еще вернемся к подробному обсуждению этих важных аргументов ниже, начиная с главы 4.

Хотя в тот вечер у бассейна Ларри оказался в меньшинстве, у цифровой утопии, в защиту которой он так красноречиво выступал, немало выдающихся сторонников. Робототехник и футуролог Ганс Моравец[5] своей книгой Mind Children 1988 года, ставшей классикой жанра, воодушевил целое поколение цифро-утопистов. Его дело было подхвачено и поднято на новую высоту Рэем Курцвейлом. Ричард Саттон, один из пионеров такой важной AI-отрасли, как машинное обучение, выступил со страстным манифестом цифро-утопистов на нашей конференции в Пуэрто-Рико, о которой я скоро расскажу.

Следующая группа мыслителей тоже мало беспокоится по поводу AI, но совсем по другой причине: они думают, что создание сверхчеловечески сильного искусственного интеллекта настолько сложно технически, что никак не может произойти в ближайшие сотни лет, и беспокоиться об этом сейчас просто глупо. Я называю такую позицию техноскептицизмом, и ее предельно красноречиво сформулировал Эндрю Ын: “Бояться восстания роботов-убийц – все равно что переживать по поводу перенаселения Марса”. Эндрю был тогда ведущим специалистом в Baidu, китайском аналоге Google, и он недавно повторил этот аргумент во время нашего разговора в Бостоне. Он также сказал мне, что предчувствует потенциальный вред, исходящий от разговоров об AI-рисках, так как они могут замедлить развитие всех AI-исследований. Подобные мысли высказывает и Родни Брукс, бывший профессор MIT[6], стоявший за созданием роботизированного пылесоса Румба и промышленного робота Бакстера. Мне представляется любопытным тот факт, что хотя цифро-утописты и техноскептики сходятся во взглядах на исходящую от AI угрозу, они не соглашаются друг с другом почти ни в чем другом. Большинство цифро-утопистов ожидают появления сильного AI (AGI) в период от двадцати до ста лет, что, по мнению техноскептиков, – ни на чем не основанные пустые фантазии, которые они, как и все предсказания технологической сингулярности, называют “бреднями гиков”. Когда я в декабре 2014 года встретил Родни Брукса на вечеринке, посвященной дню его рождения, он сказал мне, что на 100 % убежден, что ничего такого не может случиться при моей жизни. “Ты уверен, что имел в виду не 99 %?” – спросил я его потом в электронном письме. “Никаких 99 %. 100 %. Этого просто не случится, и все”.

Впервые встретив Стюарта Рассела в парижском кафе в июне 2014 года, я подумал: “Вот настоящий британский джентльмен!”. Выражающийся ясно и обдуманно, с мягким красивым голосом, с авантюрным блеском в глазах, он показался мне современной инкарнацией Филеаса Фогга, любимого мною в детстве героя классического романа Жюля Верна Вокруг света за 80 дней. Хотя он один из самых известных среди ныне живущих исследователей искусственного интеллекта, соавтор одного из главных учебников на этот счет, его теплота и скромность позволили мне чувствовать себя легко во время беседы. Он рассказал, как прогресс в исследованиях искусственного интеллекта привел его к убеждению, что появление AGI человеческого уровня уже в этом столетии – вполне реальная возможность, и хотя он с надеждой смотрит на будущее, благополучный исход не гарантирован. Есть несколько ключевых вопросов, на которые мы должны ответить в первую очередь, и они так сложны, что исследовать их нужно начинать прямо сейчас, иначе ко времени, когда понадобится ответ, мы можем оказаться не готовы его дать.

Сегодня взгляды Стюарта в той или иной степени разделяет большинство, и немало групп по всему миру занимаются вопросами AI-безопасности, как он и призывал. Но так было не всегда. В статье Washington Post 2015 год назван годом AI-безопасности. А до тех пор рассуждения о рисках, связанных с разработками искусственного интеллекта, вызывали раздражение у большинства исследователей, относившихся к ним как к призывам современных луддитов воспрепятствовать прогрессу в этой области. Как мы увидим в главе 5, опасения, подобные высказанным Стюартом, были достаточно отчетливо артикулированы еще более полувека назад разработчиком первых компьютеров Аланом Тьюрингом и математиком Ирвингом Гудом, который работал с Тьюрингом над взломом германских шифров в годы Второй мировой войны. В прошлом десятилетии такие исследования велись лишь горсткой мыслителей, не занимавшихся созданием AI профессионально, среди них, например, Элиезер Юдковски, Майкл Вассар и Ник Бострём[7]. Их работа мало влияла на исследователей AI-мейнстрима, которые были полностью поглощены своими ежедневными задачами по улучшению “умственных способностей” разрабатываемых ими систем и не задумывались о далеких последствиях своего возможного успеха. Среди них я знал и таких, кто испытывал определенные опасения, но не рисковал говорить о них публично, дабы не навлечь на себя обвинений коллег в алармизме и технофобии.